Wohl alle von uns haben sich bei der Nutzung von Generative AI schon gefragt, ob man der Antwort trauen kann. Zum einen ist nicht klar, ob die zum Training verwendeten Daten wie Zeitungsartikel und Blogbeiträge faktisch korrekt sind, zum anderen stellt sich die Frage, wie viel Bias in den grossen Sprachmodellen steckt. Klar, wir alle wollen in unseren Antworten keinen Bias. Aber was ist ein Bias? Wer bestimmt eigentlich, was ein Bias ist? Vorurteile prägen uns als Individuen und als Gesellschaft und sind nun einmal Teil der Realität. Ein Beispiel: In Führungspositionen arbeiten mehr Männer als Frauen. Dass das nicht gut ist, sind wir uns wohl alle einig. Aber es ist die Realität. Soll Generative AI in ihren Antworten nun die Welt abbilden, wie sie ist, oder wie sie idealerweise sein sollte? Und wie sieht eine solche ideale Welt aus? Ist die Vorstellung, dass es gleich viele Frauen und Männer in Führungspositionen geben soll, nicht auch wieder ein Bias – wenn auch ein positiver? Es gibt verschiedene Initiativen, um bspw. durch AI Alignment gesellschaftliche Werte in grosse Sprachmodelle zu integrieren. Dies ermöglicht es Organisationen auch sicherzustellen, dass die verwendeten KI-Tools interne Geschäftsregeln und Complianceanforderungen erfüllen. Allerdings: Grosse Sprachmodelle ganz ohne Bias zu trainieren, wird kaum möglich sein. Denn wie bei Menschen gilt auch bei künstlicher Intelligenz: Im Lernen steckt auch immer ein Bias.

Obwohl alle grossen Sprachmodelle über ethische Sicherheitsvorkehrungen verfügen, ist in den Medien regelmässig über sogenannte Jailbreaks zu lesen. Beim Jailbreaking können durch spezifische Textaufforderungen die Richtlinien zur Inhaltsmoderation (z. B. bei den Themen Rassismus und Sexismus) umgangen werden. Im besten Fall sind die durch Jailbreaking provozierten Antworten einfach nur lustig, im schlechtesten Fall können die falschen (Preisangaben, verbindliche Zusagen) und rufschädigenden (Sexismus, Rassismus) Antworten für Firmen rechtliche und finanzielle Konsequenzen haben. Mit Guardrails (Leitplanken) wird versucht, die Nutzung auf die vorgesehenen Bereiche zu limitieren und eine «Überlistung» des Chatbots zu verhindern. Mit Content-Filtern für die Fragen und die Antworten kann sichergestellt werden, dass keine unerwünschten Themen besprochen werden. Zudem kann es sinnvoll sein, dass grosse Sprachmodelle in ihren Antworten immer einen Disclaimer mitliefern, der darauf hinweist, dass die Antworten von der Nutzerin oder dem Nutzer überprüft werden sollten.

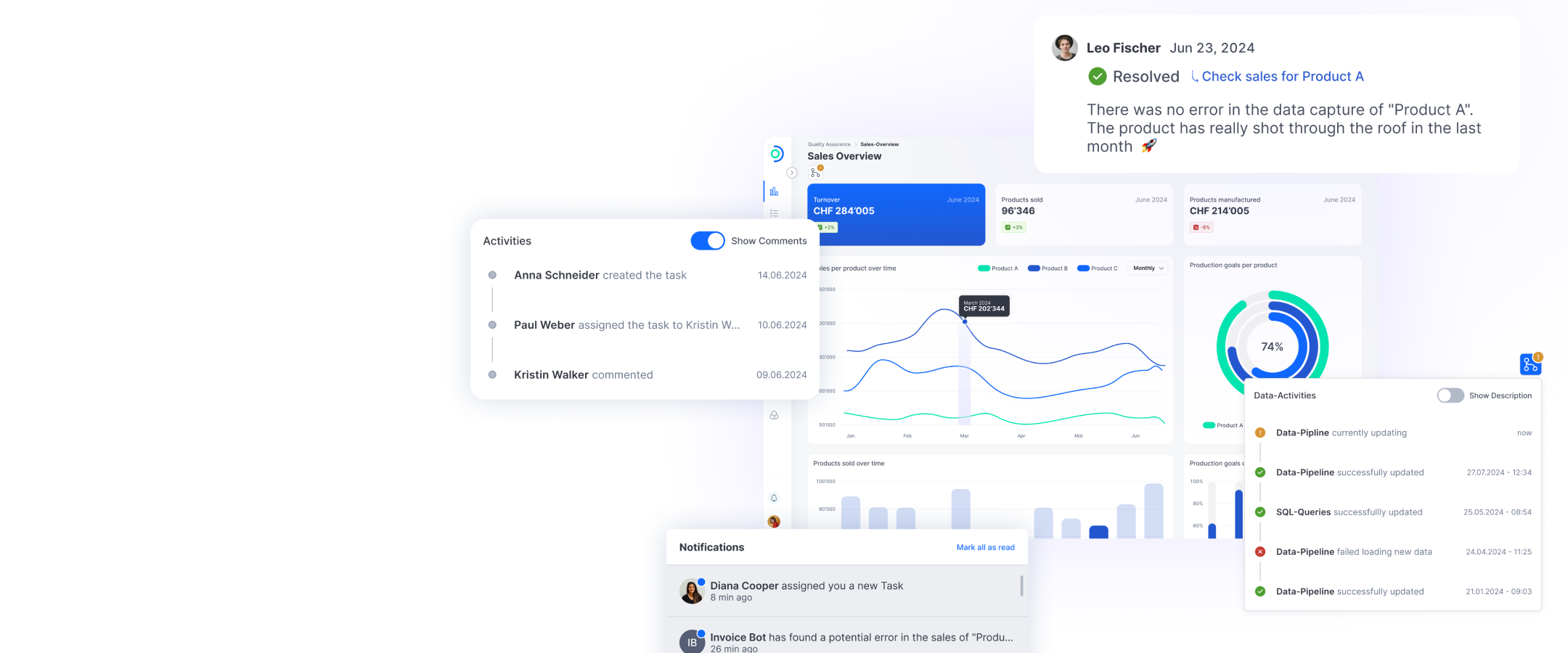

Auch das Problem der sogenannten Hallucinations, also das Generieren von falschen oder erfundenen Informationen aufgrund von Datenlücken, wurde noch nicht befriedigend gelöst. Datenlücken entstehen bpsw., weil die zum Training verwendeten Datensätze veraltet sind. Nutzt eine Organisation einen an ein LLM gekoppelten KI-Chatbot, können die verwendeten Daten Monate oder gar Jahre alt sein. Neue und spezifische Informationen über Produkte und Services fehlen, was zu falschen Antworten führt, die das Vertrauen von Kunden und Mitarbeitenden in die Technologie und schlussendlich in die Organisation untergraben. Diesem Problem kann mit Retrieval Augmented Generation (RAG) begegnet werden: RAG inkludiert aktuelle Informationen oder andere zusätzlichen Wissensquellen wie firmeninterne Daten, ohne dass grosse Sprachmodelle mit den neuen Datensätzen trainiert werden müssen. Man will die diversen Fähigkeiten der grossen Sprachmodelle nutzen, sich aber nicht auf deren «Wissen» verlassen. Weil viele Organisationen den durch KI generierten Antworten noch misstrauen, wird in die Prozesse häufig auch ein «human in the loop» eingebettet.

Eine weitere Herausforderung gibt es bei der granularen Berechtigung der Nutzerinnen und Nutzer. Nicht alle Mitarbeitenden oder Kunden sollen auf die gleichen, meist sehr sensitiven Daten zugreifen können. Es gilt, Wege zu finden, wie sensitive firmeninterne Daten so in Lösungen einzubetten, dass Mitarbeitende und Kundinnen und Kunden mit ihren Prompts nur Antworten erhalten, die auch für sie gedacht sind.