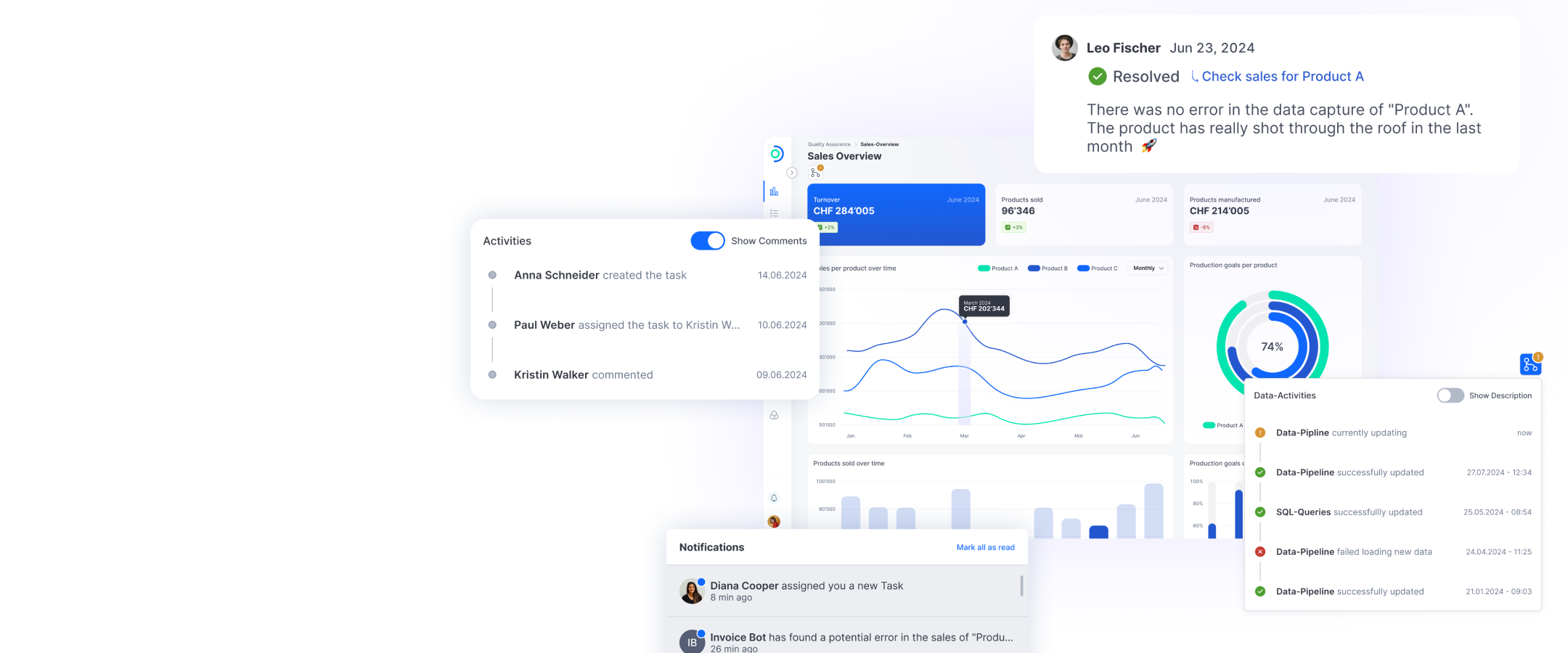

Das Bild wurde von der KI-Software DALL-E 2 mit folgendem Prompt generiert:

«Entwerfen Sie ein Bild, das die mit der künstlichen Intelligenz verbundenen Risiken für die Cybersicherheit von Unternehmen wirkungsvoll kommuniziert. Die Komposition sollte eine virtuelle Landschaft zeigen, die die digitale Infrastruktur eines Unternehmens darstellt, durch die verschiedene Datenströme fliessen. Integrieren Sie visuelle Elemente wie Datenleaks und bedrohliche Hacker oder Eindringlinge, die versuchen, in das System einzudringen. Der Stil sollte futuristisch und dynamisch sein, mit einer Mischung aus leuchtenden und dunklen Farben, um ein Gefühl von Dringlichkeit und Verletzlichkeit zu vermitteln.»

Für die breite Bevölkerung wurden die Fortschritte von KI in den letzten zwei Jahren deutlich sicht- und nutzbar: Mit Werkzeugen wie DALL-E oder Midjourney ist die Erstellung von zum Teil täuschend echt aussehenden Bildern oder Kunstwerken möglich, und ChatGPT bietet einen einfachen Zugang zu KI mittels Texteingaben. Durch die freie Verfügbarkeit solcher Modelle – ab einer gewissen Nutzung muss man die meisten bezahlen – begann der Run auf deren Verwendung. ChatGPT bspw. brauchte nur fünf Tage, um die Marke von einer Million Nutzerinnen und Nutzern zu knacken. Und alle wollen sie ein Stück vom Kuchen abhaben. So sieht sich Google zunehmend als KI-Firma und nicht, wie bis vor kurzem, als Cloud-Firma. Diese Transformation bei den grossen Herstellern führt zu einem stärkeren Wettbewerb und damit zu einer Zunahme und Verbesserung von KI, die vermutlich schon sehr bald den Weg in kommerzielle Alltagsprodukte findet. Dass die einfachere Verfügbarkeit von KI unseren Alltag und unsere Arbeit transformiert, ist klar. Weniger klar ist, welchen Weg diese Transformation einschlägt. Im Vergleich zu anderen Technologien, in denen der Nutzen auch nach Jahren unklar ist oder zumindest auf sehr spezifische Anwendungsfälle begrenzt blieb (bspw. Blockchain), haben die letzten zwei Jahre klar bewiesen: KI findet in den verschiedensten Bereiche Verwendung, und laufend kommen neue Use Cases dazu. Bereits heute bringen viele Firmen KI-unterstützte Produkte mit vielversprechenden Eigenschaften auf den Markt: Sie erstellen Texte und Präsentationen anhand bestehender Inhalte oder Anweisungen oder sortieren E-Mails und übernehmen teilweise sogar deren Beantwortung.

Cybersecurity: KI als Verbündeter …

Auch in der Informationssicherheit wird KI häufig genutzt. Sie hilft, Bedrohungen und Schwachstellen rascher zu erkennen, und ermöglicht eine schnellere und effizientere automatisierte Überwachung und Reaktion. So ist bspw. denkbar, dass Level 1 Security Operation Centre Analysts, die ohnehin einen anstrengenden und manchmal nicht gerade kreativen Job haben, andere Tätigkeiten ausführen können, während ein KI-Modell die Analyse erledigt. Klar: Die Idee, gewisse Aufgaben komplett an KI-Modelle auszulagern, klingt verlockend. Man muss aber immer wissen, wie genau die verwendeten Modelle funktionieren und was mit den eingegebenen Daten geschieht.

… und neue Gefahrenquelle

Denn eines der grossen Fragezeichen bei der Nutzung von KI ist die fehlende menschliche Überwachung. Obwohl Modelle mittlerweile in der Lage sind, komplexe Aufgaben auszuführen, sind sie alles andere als perfekt und können falsche Schlüsse ziehen. Um die Richtigkeit der von diesen Modellen generierten Ergebnisse zu prüfen, muss die menschliche Überwachung und Entscheidungsfindung in den Prozess integriert werden. Denn die Generierung von Fehlinformationen ist relativ häufig, da die auf KI basierenden Modelle versuchen, ihr eigenes «Unwissen» zu verstecken und falsche Antworten erstellen. Aus Sicht der Informationssicherheit ist die Verhinderung von Datenmissbrauch eine der grossen Herausforderungen bei der Nutzung von KI-basierten Tools und anderen datenverarbeitenden Plattformen. KI-Modelle können dazu gebracht werden, Informationen preiszugeben, die nicht für die Öffentlichkeit bestimmt sind, oder sie verwenden die zur Verfügung gestellten Informationen nicht zweckgemäss. Es besteht auch die Gefahr, dass KI den Benutzer oder die Benutzerin dazu verführt, Informationen preiszugeben, die beispielsweise nicht ausserhalb der Firma verwendet werden sollten. Es gab bereits mehrere Fälle, in denen Mitarbeitende vertrauliche Informationen der Firma in KI-Modelle eingespeist hatten und diese Informationen dann öffentlich zugänglich waren.

Gefährliche Eigendynamik

Wir befinden uns erst am Anfang einer flächendeckenden Nutzung von KI-Tools. Die hohe Komplexität von KI macht es schwierig, die potenzielle Gefahr ihrer Nutzung für die Cybersecurity vorherzusagen. Die Komplexität von KI ist für Benutzerinnen und Benutzer ohne Hintergrundwissen schwer verständlich, aber selbst Expertinnen und Experten können nicht immer erklären, warum KI-Modelle zu einer bestimmten Aussage oder Entscheidung gelangen. Es besteht die Gefahr, dass KI eine Eigendynamik entwickelt, die nicht angemessen gesteuert werden kann.

Am Ende bleiben nur Spekulationen

Ob, wann und wie die erwähnten Gefahren eintreten, kann niemand – nicht einmal ChatGPT – beantworten. Wie andere Werkzeuge auch kann KI unseren beruflichen und privaten Alltag verbessern, in den falschen Händen aber schnell zu einer neuen Gefahr werden. Interessant ist zu sehen, welche Einschränkungen die Hersteller ihren künstlichen Intelligenzen mitgeben und als wie effizient sich diese Einschränkungen herausstellen. Schon heute äussern sich KI-Forscherinnen und -Forscher kritisch zur allgemeinen Lageentwicklung und fordern Entwicklungsmoratorien oder eine Regulierung durch den Staat. Ob dies notwendig ist und ob solche Massnahmen überhaupt effektiv genug sind, wird die Zukunft zeigen.